Les vidéos truquées ou “deepfake” en anglais, ont fait leur apparition sur la toile. Les problème est qu’elles sont de plus en plus réalistes. Ainsi comment les détecter ? Une piste consisterait à identifier le clignement des yeux des personnages.

Des vidéos qui peuvent déstabiliser des gouvernements

En juin dernier, une vidéo montrant Datuk Seri Azmin Ali, le ministre malaisien de l’économie, en train d’avoir une relation avec Muhammad Haziq Abdul Aziz, un secrétaire adjoint du ministre, a fait surface en ligne. La vidéo s’est répandue comme une traînée de poudre, et a ensuite déclenché une frénésie médiatique dans le pays. En effet, cette vidéo a eu des conséquences réelles et Abdul Aziz, qui, aux yeux du gouvernement, avait commis un crime, a été rapidement arrêté avant d’être relâché.

Mais, selon le premier ministre malaisien, la vidéo n’était que l’une des innombrables autres vidéos truquées ou “deepfake” en anglais, peu précises qui ont trouvé leur chemin sur Internet l’année dernière.

Qu’est ce qu’un deepfake ?

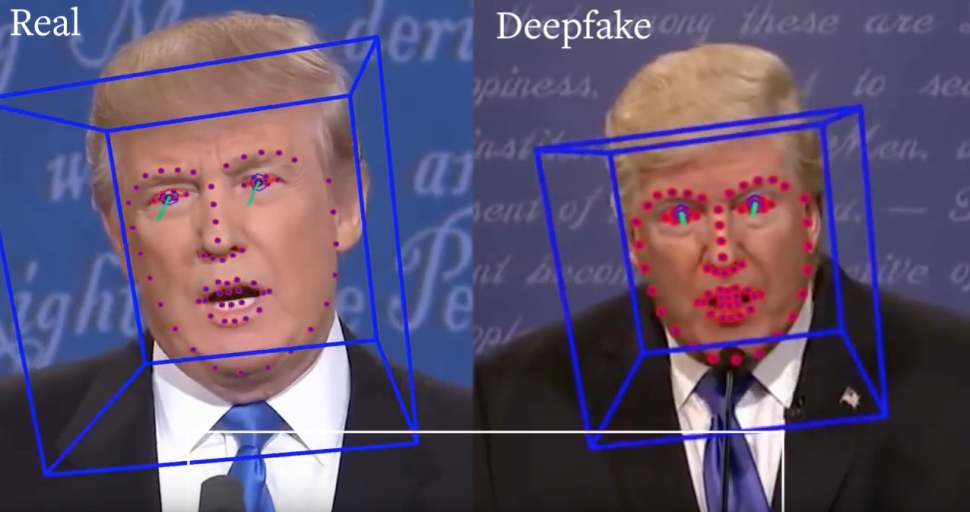

Le deepfake ou l’hypertrucage est une technique de synthèse d’images basée sur l’intelligence artificielle. Elle sert principalement à superposer des images et des vidéos existantes sur d’autres images et/ou vidéos (par exemple : le changement de visage d’une personne sur une vidéo comme très bien décrypté récemment par France TV). Le terme “deepfake” est un mot-valise formé à partir de deep learning (« apprentissage profond ») et de fake (« faux »). Ainsi, Cette technique est utilisée pour créer des infox et des canulars malveillants

Des “deepfake” incroyablement réels

Les “Deepfake” sont basées sur ce qu’on appelle un réseau antagoniste génératif (GAN). Il se compose de deux processus intelligents artificiels. Ces derniers – un générateur et un discriminateur – s’opposent l’un à l’autre. Le générateur et le discriminateur reçoivent tous deux de l’information, et le discriminateur réussit de mieux en mieux à distinguer le vrai du faux. Cela oblige le générateur à créer de meilleurs faux qui peuvent tromper l’IA discriminante, ce qui nous donne certains des “deepfake” incroyablement réels que nous voyons aujourd’hui.

Bien que la vidéo ait pu sembler suffisamment authentique pour que les autorités puissent arrêter le secrétaire du ministre, les experts n’ont tout simplement pas pu déterminer si le clip était réellement légitime ou non. Et c’est le problème que nous avons aujourd’hui avec les “deepfake” – si les experts ne peuvent pas identifier une vidéo truquée, alors comment une personne normale peut-elle même commencer à essayer de le faire ?

Cette technologie évolue et il sera de plus en plus difficile pour une personne ordinaire de la reconnaître, parce que c’est certainement difficile en ce moment

Galina Alperovich, Chercheuse au sein de la société Avast

“Cette technologie évolue rapidement. Il sera de plus en plus difficile pour une personne non formée de la reconnaître. En effet, c’est difficile actuellement “, explique Galina Alperovich, chercheuse principale en “machine learning” chez Avast. Cependant, certains indicateurs peuvent alerter le public.

Spectre, un projet artistique co-créé par Bill Posters

En mai dernier, Bill Posters a co-créé Spectre, un projet artistique. Mark Zuckerberg y parle de façon convaincante de la façon dont il contrôle des millions de données personnelles.

La vidéo est devenue virale. Ensuite, Posters a créé des vidéos truquées de Donald Trump, Kim Kardashian et Freddie Mercury pour en montrer les possibilités.

Ainsi, nous pouvons repérer certains indices dans une fausse vidéo. La plupart se trouve dans le visage du personnage et dans la zone située entre le menton et le nez.

“Nous pouvons rechercher différentes choses sur le plan technique dans ces vidéos “, explique M. Posters. “Dans les contours des parties du visage, comme des marques de flou, une image estompée ou une décoloration”

Les faux personnages cligneraient moins des yeux

Selon de l’Université Cornell suggèrent également que les yeux peuvent être un signe que la vidéo est un “deepfake”. Ainsi, le personnage clignerait moins des yeux.

Dans une étude publiée en 2018, les chercheurs ont utilisé le machine learning pour analyser l’ouverture et la fermeture des yeux. Pour cela, ils ont développé un réseau neuronal pour identifier la vitesse à laquelle les gens clignent des yeux dans les vidéos. Avec les vidéos truquées, le sujet cligne souvent beaucoup moins des yeux qu’un vrai personnage.

“Des signes comme le clignement des yeux et la fréquence de ces clignements peuvent être un peu trompeurs. Mais aussi des signes de manque de synchronisation de la parole avec le mouvement des lèvres et de décalage émotionnel”, explique Sabah Jassim. Un expert professeur de mathématiques et d’informatique à l’Université de Buckingham.

“Parfois ce sont des choses de base, mais il y a d’autres possibilités que vous pourriez remarquer. Vous pourriez trouver des éléments tremblants et aussi flous à certains endroits que vous n’attendez pas. Mais aussi l’apparence de certains objets.

Le nombre de vidéos “deepkfake” a doublé en 10 mois

Mais les “deepfake” s’améliorent constamment, et il sera de plus en plus difficile de les repérer. Ce mois-ci, un rapport de la société de cybersécurité Deeptrace a révélé que le nombre de “deepfake” diffusés en ligne a doublé en moins d’un an. Ils sont passés de 7 964 en décembre 2018 à 14 698 dix mois plus tard. La société a déclaré que 96% de ce contenu était pornographique. Ainsi, même si les “deepfake” peuvent avoir un impact sur la politique, ils continuent d’être créés comme ils l’ont été à l’origine.

Depuis la sortie des vidéos virales de Bill Posters et les vidéos trafiquées aujourd’hui, les “deepfake” sont non seulement devenus plus importants, mais aussi de plus en plus sophistiqués. Quelles sont les pistes pour mieux les identifier ?

Nous avons tendance à faire confiance aux sources vidéo

Bill Posters

Devenez plus compétents en matière de numérisation, affirme M. Posters. “Nous devons être plus critiques à l’égard des types d’information qui nous sont transmises en ligne. En effet, les “deepfake” sont des expériences multicentriques, c’est audio, c’est visuel “, explique-t-il. “Nous avons tendance à faire confiance aux images diffusées ; nous avons tendance à faire confiance aux images en mouvement.”

Alperovich est d’accord, disant que nous ne donnons pas souvent aux vidéos suspectes l’attention qu’elles méritent. “Les gens aiment souvent les vidéos sur Twitter sans savoir d’où elles viennent, dit-elle. “Il n’y a donc pas toujours une source particulière pour la vidéo. Tu vois la vidéo et tu ressens une émotion.”

L’IA appelée à l’aide pour déceler le vrai du faux

Mais il y a un moyen de savoir si une vidéo est un “deepfake”, ironiquement, en utilisant l’IA. Dans une étude de l’Université de Berkeley et de l’Université de Californie du Sud, les chercheurs utilisent l’IA pour analyser le style de langage. Mais également les mouvements du visage et du corps des politiciens. Comme par exemple, la façon dont Donald Trump peut sourire après avoir dit quelque chose. Dans l’étude, l’IA était exacte 92 % du temps pour la détection d’une vidéo “deepfake”.

Bien sûr, maintenant que les créateurs de “deepfake” sont conscients de cet oubli, ils peuvent simplement commencer à les mettre en place dans leurs scenarios. Cela devient le jeu du chat et de la souris.

Ainsi, nous devons former chaque IA afin de garder une longueur d’avance sur les autres, car nous ne pourrons pas toujours compter sur les artefacts “visibles”.

“Beaucoup de ces petits détails disparaissent rapidement. Toutes les vidéos ont des artefacts à cause de la compression, et ceux-ci mènent à des artefacts vraiment bizarres “, dit Hamy Farid, professeur d’informatique et de criminalistique numérique à l’UC Berkeley et co-auteur de l’étude.

Google a publié un kit de formation anti “deepfake”

En reconnaissance de la menace que représentent les “deepfake”, Google a publié un kit de formation anti “deepfake” pour les chercheurs afin de tester leurs méthodes de détection.

“Lorsqu’on cherche des artefacts visuels, il faut faire preuve d’une grande prudence pour faire la différence entre les artefacts attendus de la compression et les artefacts attendus de la synthèse, dit Farid.

“Et si vous ne connaissez pas vraiment la différence entre les deux, vous pouvez les confondre facielement.”

En fin de compte, il va devenir de plus en plus difficile d’identifier un “deepfake” avec les artefacts les plus courants. C’est pourquoi, nous devrons nous fier à notre culture numérique et à l’IA des chercheurs pour réfuter toute vidéo douteuse.

Sources : The Star, bigdata.fr, Bill Posters, Francetv.fr, Université Cornell, Deeptrace, Universités de Berkeley et de Caroline du Sud, ai.googleblog.com. Article original publié sur le site wired par Alex Lee.