Un bot correspond à une succession d'énoncés entre un système technologique et un utilisateur.

Crédits photos : pch.vector (Freepik)

Sans ce que l’on s’en rende compte, bots et assistants vocaux ont conquis notre vie quotidienne. Tous ces voice, call et chat bot génèrent-ils un simple effet “wahou” ou sont-ils une grande prouesse technologique ? Carole Lailler, Docteur en Sciences du Langage et consultante en intelligence artificielle, nous donne des premiers éléments de réponse.

Le bot : c’est quoi et ça fonctionne comment ?

On ne badine pas avec l’amour de la conversation, elle est bien trop importante et essentielle à l’humain pour ça. Pour autant, il n’est pas rare, aujourd’hui, d’entrer en interaction avec un bot. Les systèmes de dialogue et autres assistants vocaux plus ou moins fins, sont partout :

- dans une galerie commerciale pour retrouver son chemin, c’est le voicebot qui capture les mots de votre voix mais peut rester aphone en retour ou, au contraire, vocaliser sa réponse et donc l’itinéraire,

- au téléphone avec son assureur pour déclarer un sinistre, c’est le callbot qui, malgré les grésillements de la ligne, opère comme le voicebot et répond forcément, lui, de sa plus ou moins douce voix,

- à travers un écran sur le net, c’est le chatbot, celui qui s’agite en bas à droite car il veut absolument vous aider.

Mais sommes-nous réellement entrés en conversation avec ce type d’interactions artificielles, ou cherchons-nous seulement à agir sur le monde en obtenant une réponse ou un service ?

Avant même de s’interroger sur les notions d’anthropomorphisme et de situations d’énonciation – un “je” identifié parle à un “tu” en partageant quelques bribes d’un univers de référence – il convient de s’arrêter quelques instants sur le “quoi” et le “comment”, parce qu’après tout : ça marche comment un bot ?

Définition et explications

Tout d’abord, il faut absolument avoir en tête qu’un bot, aussi peu élaboré soit-il, correspond “simplement” à une succession d’énoncés entre un système technologique et son utilisateur. Qu’on le nomme agent conversationnel parce qu’il est incarné dans une enveloppe de métal, ou assistant intelligent car il relève du service à autrui (et déduit alors mathématiquement d’un contexte des éléments de réponse), un système de dialogue permet avant tout de causer en langue naturelle sans emprunter les chemins d’un galimatias codé ou autres amphigouris abscons. On blablate et ça répond… sans autre forme de procès et/ou de contraintes !

Toutefois il s’agit là d’une vision simpliste, la réalité étant tout de même un tantinet différente : un bot est une brique technologique qui reste plurielle… Eh oui, même sans reconnaissance de la parole en entrée ou de synthèse en sortie car la médiation reste uniquement textuelle, le bot est une chaîne de traitements.

Non seulement, une phase de compréhension de l’intention du locuteur doit être convoquée (quel domaine, quelle demande, quels éléments apportés pour retrouver ce que l’on questionne ?). Mais il est également nécessaire de savoir où l’on en est du dialogue (le merci de la première question n’est pas celui qui clôt le débat). Enfin, il faut penser à renvoyer une réponse sous une forme ou une autre (allumer la lumière ou affirmer, preuves à l’appui, que la Nouvelle Zélande compte effectivement plus de moutons que d’habitants), sur le “bon” canal, en mettant à jour si besoin la “bonne” case de la base de données et en agrémentant (ou pas) la réponse des “bonnes” informations annexes et d’un soupçon de politesse.

En effet, contrairement aux idées reçues, les usagers usent de toutes les formules de politesse apprises plus jeunes et gardent une spontanéité conversationnelle aussi déconcertante qu’imagée et parfois fleurie !

De la profondeur de l’interaction

Alors, qu’on opte pour un bot orienté tâches à l’aide d’une combinaison de règles fondées sur des connaissances précises et quelques modèles statistiques, ou qu’on choisisse de privilégier l’interaction à travers des méthodes de recherche d’informations et des modèles neuronaux : comment parvenir à converser sans forcément baratiner ou paraître intrusif ?

Car si l’on pressent le possible effet waouh, il n’en reste pas moins qu’un système dialogique peut parfaitement se planter et donner le sentiment de manquer de discernement. Ainsi, dès 1966, le premier bot, nommé Eliza, offusqua grandement la secrétaire de son concepteur, Joseph Weizenbaum, en renvoyant à cette dernière un élément d’interrogation sur un aspect on ne peut plus intime, sa mère. En effet, ce système, construit sur une simulation d’entretien avec un psychothérapeute rogérien, avait comme solution de repli l’interrogation affective emblématique “parlez-moi de votre mère”.

Lorsqu’aucune réponse n’est possible, le dialogue tourne littéralement court. Or, un dialogue, est-il besoin de le rappeler, c’est d’abord et avant tout un locuteur qui s’entretient avec un interlocuteur. C’est un “je” qui parle à un “tu” avec lequel il partage un univers de références. Mais les références bougent et fluctuent au gré de nos cultures, biais et apprentissages. Tout comme on doit impérieusement réactualiser les connaissances d’un système, chacun d’entre nous se fait fort d’oublier, d’écraser d’anciennes opinions par de nouvelles, d’effacer purement & simplement ou bien de pérenniser par concaténation.

La relation homme-machine continuellement en question

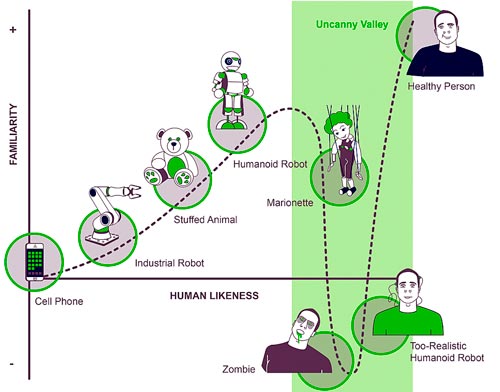

Même lorsque l’interlocuteur n’est autre que soi-même, l’altérité et la distance sont là. Or, la distance à l’autre, au presque soi mais qui n’est pas complètement son ego, est justement discutée dans le schéma de l’Uncanny Valley. Cette “vallée de l’étrange” joliment dessinée par le japonais Mori Masahiro montre à quel point le lien à l’humain interroge lorsqu’il se fait plus ténu : un cadavre, un zombie dérangent et c’est la chute au fond de la vallée. Cependant, quid d’une peluche jappante aux poils roses criards, quid d’une main articulée à une époque où les exosquelettes permettent aux soldats blessés de recouvrer la marche ?

De même, le robot humanoïde tend à moins effrayer. Il questionne désormais moins devant l’écart qui s’accroit. On sait de plus en plus que ce serviteur reste limité à ses cercles d’usage et d’obéissance. Même quand il prend les traits d’un canidé imposant, on rit de son déhanchement saccadé et on l’imagine davantage comme un adjuvant au déménagement qu’à la surveillance de la brebis gestante… même si la marmotte n’en finirait pas de siffler.

Certes, les pires scenarii prédisent le remplacement de l’humain par ces machines mais dans quelles mesures : tout ou en partie ? Porter une charge lourde peut-être, savoir jouer à Tetris en optimisant la maintenance, à la rigueur, mais converser ? On me rétorquera que de nombreux bots passent avec succès le fameux test de Turing. Ce à quoi, je répondrai : qui passe le test ? Le bot par sa capacité à se jouer de moi en me laissant dans le doute d’une possible humanité ? Ou moi, par mon manque de discernement lié à ma fatigue, mon enthousiasme ou ma crédulité plus ou moins feinte ? L’humain aime flirter avec ses peurs mais n’en oublie pas d’être inventif & d’activer ses fonctions de discernement.

Un effort de badinage impossible ?

Ces derniers temps, on raconte que la hype du bot s’essouffle. Face au brouhaha des démos plus ou moins sorties d’un studio de cinéma américain à gros budgets, on revient à un outil “ceinture et bretelle” plus proche du Serveur Vocal Interactif où tout est planifié et orchestré en amont afin de “faire le job” ou qui, au contraire, exacerbe l’irritation de l’utilisateur. Est-ce à dire qu’un arbre de décisions est dépassé ?

Non, évidemment cet arbre ne cache pas la forêt mais tend à faire d’un jardin anglais un jardin à la française. Il a pour objectif, en effet, à chaque noeud, de réduire le problème à une seule et unique question pour laquelle deux chemins de réponse se dessinent jusqu’à ce qu’il ne reste qu’une seule classe. Les arbres peuvent alors être le fruit d’un arrachage de cheveux humains, ou bien construits par un algorithme dont la tâche revient à maximiser le partage à chaque noeud. Ce manichéisme s’avère fort efficace lorsqu’il s’agit d’opérer sur un monde circonscrit où les thématiques sont identifiables et identifiées, où le vocabulaire n’est ni trop métaphorique ni trop polysémique, où il s’agit de rendre un service pragmatique.

En revanche, si les demandes qu’on souhaite satisfaire nécessitent gestions d’historique, interactions complexes, entremêlements d’usages langagiers provenant de communautés de locuteurs ou de scripteurs différentes, convocation de noms propres, de dates, de montants voire quelques notes d’humour, il est alors préférable d’en passer par un traitement plus sioux fondé sur de la détection de concepts (ou slot filling). Dans ce cas, il s’agit de re-trouver les concepts convoqués dans l’énoncé pour mieux les associer aux mentions dans leurs usages langagiers propres à chacun.

Derrière l’intelligence artificielle, des données

Toutefois, un seul maître-mot est à convoquer pour que ces agents dialogiques soient réellement cognitifs : la récolte de données. En effet, le cognitif n’est pas enfermé dans les briques technos, qu’elles soient plus ou moins noires. Il est dans les cartographies réalisées en amont, dans le relevé des usages langagiers à travers quelques comptages de mots et de ngrams, de relevés de caractéristiques lexicales, acoustiques & prosodiques. À quelle typologie de locuteurs avons-nous le plus affaire (âge/genre/accents), quels sont les thèmes abordés, quel vocabulaire en contexte, quels us et coutumes remarquables ? Bref qu’on cherche à nourrir un système expert ou une architecture à base de Transformers, essayer de séparer le bon grain de l’ivraie dans les corpus glanés est indispensable et reste la clé du succès.

L’évaluation n’en sera que simplifiée puisqu’on limitera les quiproquos à quelques mots hors-vocabulaire ou/et à quelques utilisateurs faisant du mauvais esprit. Ainsi, les métriques n’en seront que plus clairvoyantes et les expériences perceptives auprès des utilisateurs que plus ciblées. Un tandem gagnant puisque débarrassé des aléas des biais de corpus trop imposants. Il en va de même pour les small talks : ces notes d’humour, véritables interactions dans l’interaction qu’il convient de ne pas oublier ; retrouver les traits sémantiques et lieux communs prêtés à l’entreprise pour mieux s’en jouer (l’appétit pour un bot centré nutrition, la grève pour celui du transport…) !

Vocal or not, that is the question?

Enfin, le bot est un “outil” qui se dit vocal. Qu’entend-on exactement par cet adjectif qui relève aussi bien de la voix et de la physiologie des cordes (dents, langue, ouverture de la bouche et nez sont également convoqués) que des paroles que l’on profère avec plus ou moins de bonheur ?

Quand il travaille avec, en entrée, le signal de la voix de son utilisateur (et des bruits environnants qui l’accompagnent), on ajoute de facto une brique de reconnaissance de la parole. Ce n’est, hélas et quoiqu’en disent certains GAFAM, pas toujours trivial à mettre en place surtout lorsqu’il s’agit d’une prise de parole spontanée avec son cortège de faux-départs, de reprises, d’errances lexicales et de disfluences (les ben et autres euhhhh dont la longueur est parfois déconcertante). En effet, un Système de Reconnaissance Automatique de la Parole doit retrouver, en temps réel, les mots (& presque mots) prononcés.

Pour autant, l’effort ne reste pas vain à condition de modéliser la langue, ses usages langagiers cibles, les accents et les sons. Le modèle de langage va s’occuper de caractériser, sans visée normative aucune, la grammaire d’une époque d’un groupe de locuteurs, d’une région ou d’une profession ou tout ceci à la fois. Le modèle acoustique, quant à lui, sera dédié au plein air ou au studio, au téléphone ou à la voiture. Il conviendra de l’architecturer pour le rendre robuste aux circonstances et à la musicalité de l’air en somme.

En dernier lieu, le dictionnaire de phonétisation jouera les variations pour faire correspondre aux lettres les possibilités de prononciation possible, sans regard moqueur pour l’accent de l’usager. Évidemment, on peut aujourd’hui modéliser tout ceci dans un End2End neuronal, sans se soucier techniquement de la tri-partition. Pour autant, on l’embarquera linguistiquement & sémantiquement ! Il sera souhaitable, pour ne pas perdre de mots en route en les noyant par la masse du plus courant, de travailler ses corpus d’apprentissage en amont.

Quid de la vocalisation de la réponse du bot ?

Ce premier ajout à la chaîne “botique” de traitements peut se voir doubler d’un second mais ce dernier reste sujet à caution. Car si restituer la réalité des discours d’un utilisateur à partir de ses paroles demeure une fonctionnalité incontournable pour le téléphone et dans quelques cas d’usage (avec des enfants non scripteurs ou des locuteurs allophones par exemple), il n’est pas toujours évident, en revanche, de proposer une synthèse en sortie de chaîne. Que ce soit pour un respect de la confidentialité (qui a envie de se voir confirmer son code secret à l’oral ?) ou parce que l’environnement ne s’y prête pas (qui oserait le voicebot dans un aéroport pour un enregistrement ?), la vocalisation de la réponse ne constitue absolument pas un passage obligé.

Raison de plus, quand on la convoque, pour la soigner et prêter une oreille attentive à cette petite ou grosse voix. Liée au Persona du bot mais aussi à la ligne éditoriale de l’entreprise, elle vient concrétiser la réussite de l’échange ou pousser à son paroxysme l’agacement. Pourtant, elle n’est “que” la dernière brique et cette inextricable liaison doit être expérimentée et évaluée. Ainsi, des tests perceptifs auprès d’usagers cibles permettent de vérifier le caractère utile et agréable de la vocalisation, d’assurer une lisibilité orale sans pour autant tomber dans les biais et facilités de la douceur de la voix du GPS. En définitive, pour éviter le sa-bot-age, rien ne vaut un regard de bot-aniste sur les données en conditions écologiques.